APEP cierra su 15º aniversario con un evento sobre los desafíos legales de la Inteligencia Artificial

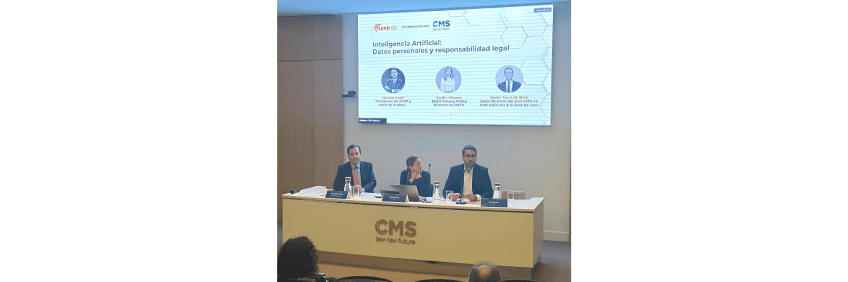

Marcos Judel, presidente de APEP y socio de Audens, fue el encargado de moderar esta sesión en la que participaron Cecilia Álvarez, EMEA Privacy Policy Director en Meta, y Javier Torre de Silva, Socio Director Área TMC en CMS Albiñána y Suárez de Lezo.

Madrid, 18 de diciembre 2024

La Asociación Profesional Española de Privacidad (APEP), en colaboración con CMS Suárez & Albiñana de Lezo, celebró el evento ‘Inteligencia Artificial: Datos personales y responsabilidad legal’, una jornada que puso el broche de oro al 15º aniversario de la asociación y en la que expertos invitados debatieron en torno a la Inteligencia Artificial, abordando temas como el acceso a datos para entrenar modelos, los marcos regulatorios y la atribución de responsabilidades en un ecosistema cada vez más complejo.

Marcos Judel, presidente de APEP y socio de Audens, fue el encargado de moderar esta sesión en la que destacó los retos a los que deben enfrentarse los profesionales y empresas que trabajan con este tipo de tecnologías, así como la relevancia de los expertos en privacidad para guiar a las organizaciones hacia el cumplimiento: “En el desarrollo de la inteligencia artificial, contar con especialistas en privacidad es una inversión estratégica y esencial para un crecimiento empresarial sostenible en la era digital”.

Los ponentes analizaron los desafíos que plantea la IA, especialmente en relación con la gestión de datos personales, un recurso indispensable para entrenar los modelos. Cecilia Álvarez, EMEA Privacy Policy Director en Meta, destacó la pérdida de competitividad europea frente a otras regiones debido, principalmente, a un marco normativo que requiere ajustes para acelerar la innovación: “Europa necesita certidumbre. No podemos llegar tarde en la creación de motores de innovación que marcarán el futuro”.

Europa ha liderado esfuerzos para regular la IA con un enfoque ético, centrado en proteger derechos fundamentales como la privacidad y la seguridad. El Reglamento de Inteligencia Artificial, en concreto, introduce un enfoque basado en el riesgo, clasifica los sistemas de IA en niveles (alto, medio y bajo riesgo) y establece requisitos específicos para cada categoría. Asimismo, impone obligaciones a desarrolladores de sistemas IA, como garantizar trazabilidad, auditar algoritmos y proporcionar explicaciones claras de cómo funcionan. Este enfoque, que busca un equilibrio entre proteger derechos y fomentar la innovación, no obstante, enfrenta críticas por las barreras que puede suponer para la competitividad de las empresas.

A este respecto, Cecilia Álvarez destacó las restricciones en el acceso a datos: “La IA necesita grandes volúmenes de datos para entrenar modelos. Sin embargo, normativas como el RGPD (Reglamento General de Protección de Datos) limitan el uso de datos personales, lo que obliga a las empresas europeas a buscar bases legales, como el consentimiento, que ralentizan sus avances”.

Además, cumplir con estas normas puede requerir inversiones significativas en auditorías, certificaciones y adaptaciones tecnológicas, algo que las empresas de otras regiones (como EE. UU. o China) no enfrentan al mismo nivel, al adoptar enfoques más flexibles que permiten a sus empresas avanzar más rápidamente en el desarrollo de modelos y motores de IA.

“La normativa europea impone principios como la minimización de datos, que exige usar solo la información estrictamente necesaria, y dificulta el acceso a datos a gran escala. Sin acceso adecuado a datos de entrenamiento, los modelos europeos pueden ser menos precisos o relevantes. Es necesario explorar bases legales alternativas al consentimiento, que permitan entrenar modelos con garantías legales”, destacó Álvarez, para quien no es viable excluir de los modelos todo dato de carácter personal. “Los sistemas generativos no perfilan a nadie, funcionan con vectores de probabilidad, y el enfoque legal debería adaptarse a esta realidad técnica”, subrayó.

¿Quieres ver la grabación de la sesión?

Puedes acceder a la grabación de la sesión completa a través del Área Privada exclusiva para asociados APEP, previo inicio de sesión.

¿Quién es el responsable de los daños causados por una IA?

Javier Torre de Silva, Socio Director Área TMC en CMS Albiñána y Suárez de Lezo, abordó la complejidad del régimen de responsabilidad, destacando la dificultad de identificar repsonsables y establecer nexos causales en los daños causados por IA.

“El mapa de responsabilidad es enormemente complejo”. La IA introduce complejidades que no se encuentran en productos o tecnologías tradicionales lo que dificulta identificar quién es imputable, si el operador, el responsable del despliegue, o el propio usuario.

“Entre los posibles candidatos a ser responsables, está el operador que según la Ley de IA puede ser un proveedor, fabricante del producto, responsable del despliegue, representante autorizado, importardor o distribuidor. En este sentido, el candidato obvio es el responsable del despliegue, que según indica la ley es una persona física o jurídica, o autoridad publica,órgano u organismo que utilice un sistema IA bajo su propia autoridad, salvo cuando su uso se enmarque en una actividad personal de carácter no profesional”, explicó Torre de Silva.

Para establecer la responsabilidad por daños en entornos de Inteligencia Artificial, Europa está actualizando y creando nuevas normativas. Entre ellas, Directiva (UE) 2024/2853, de 23 de octubre de 2024, sobre responsabilidad por daños causados por productos defectuosos, que mantiene varios de los puntos de la Directiva de 1985. “Solo es para personas físicas, sigue siendo responsabilidad objetiva, sigue siendo responsabilidad por defectos, sigue excluyendo los servicios y sigue excluyéndose lo imprevisible e inevitable según el estado de la técnica”. No obstante, introduce algunas novedades como que, a petición del demandate, “se exigirá al demandado que exihiba las prubeas pertinentes de que disponga excepto secreto comercial. Lo mismo para el demadante a petición del demandado. Si el demandado no las aporta, se presume iuris tantum el defecto y el nexo causal”, ha explicado Torre de Silva.

Asimismo, la Comisión Europea, en 2022, presentó la propuesta de Directiva sobre responsabilidad en materia de IA, con el objetivo de actualizar el régimen de responsabilidad civil para adaptarlo a los desafíos que plantea la IA en el entorno digital.

No obstante, indicó Javier Torre de Silva, “todo el derecho se resumen en responsabilidad, en cumplir. De nada sirve hacer un montón de regulaciones si al final nadie responde por los daños, es importante establecer reglas claras sobre la IA, porque a día de hoy son todavía ineficientes”.

Sobre APEP

La Asociación Profesional Española de Privacidad (APEP) ha cerrado su 15 aniversario con más de mil asociados expertos de diversas disciplinas que han desempeñado un papel crucial como impulsores de un entorno digital más seguro y ético. A lo largo de estos años, la asociación se ha consolidado su posición como asociación de referencia en materia de privacidad y protección de datos en España, contribuyendo al desarrollo y aplicación de políticas y normativa clave en la materia a través de su labor formativa, de certificación, y grupos de trabajo que actúan para mejorar las políticas de protección de datos y privacidad y proporcionar una orientación sobre la interpretación e implementación de la normativa.

A la largo de su trayectoria APEP se ha convertido en el lugar de encuentro y colaboración de los DPOs y otros profesionales de la privacidad creando espacios comunes de diálogo en materia de privacidad especialmente necesarios en el contexto actual.

¿Todavía no eres asociado APEP?

Disfruta de todas las ventajas de ser Asociado APEP dándote de alta.